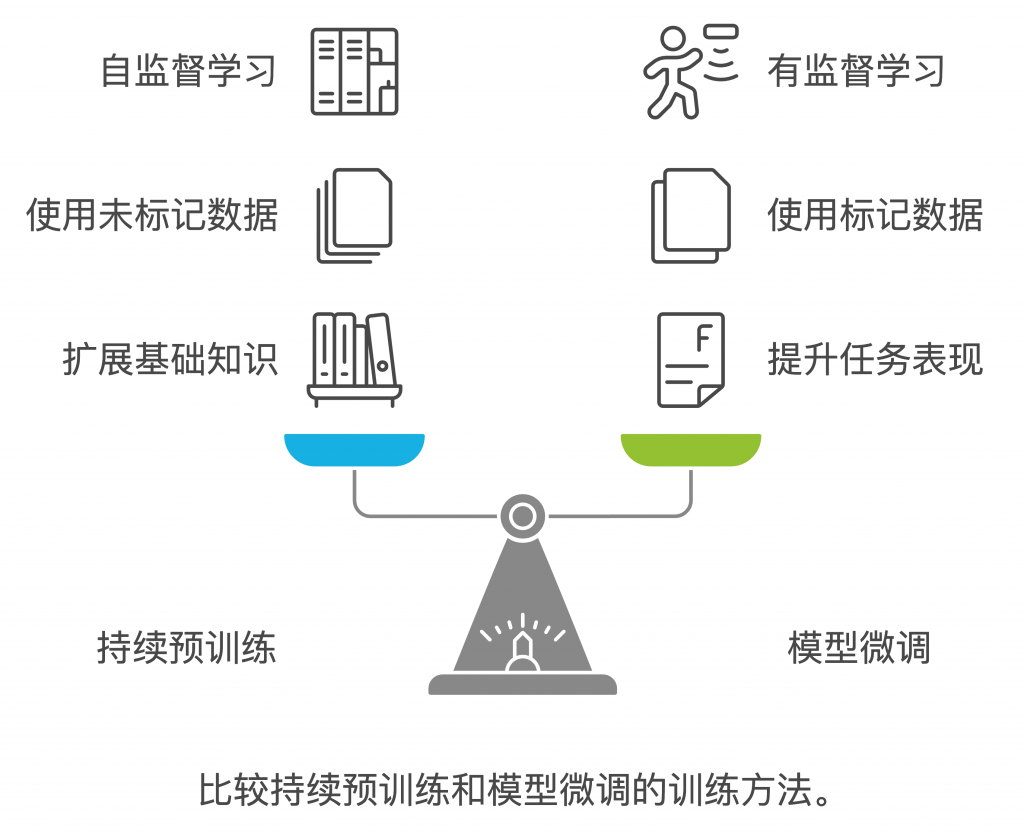

基本概念对比

持续预训练(Continuous Pre-training):

- 定义:在原始预训练模型基础上,使用新数据继续进行大规模预训练

- 目的:扩展和更新模型的基础知识

- 数据类型:主要使用未标记数据

- 训练方式:自监督学习

模型微调(Fine-tuning):

- 定义:针对特定任务或领域,对预训练模型进行小规模定向训练

- 目的:提升模型在特定任务上的表现

- 数据类型:主要使用标记数据

- 训练方式:有监督学习

具体用例对比

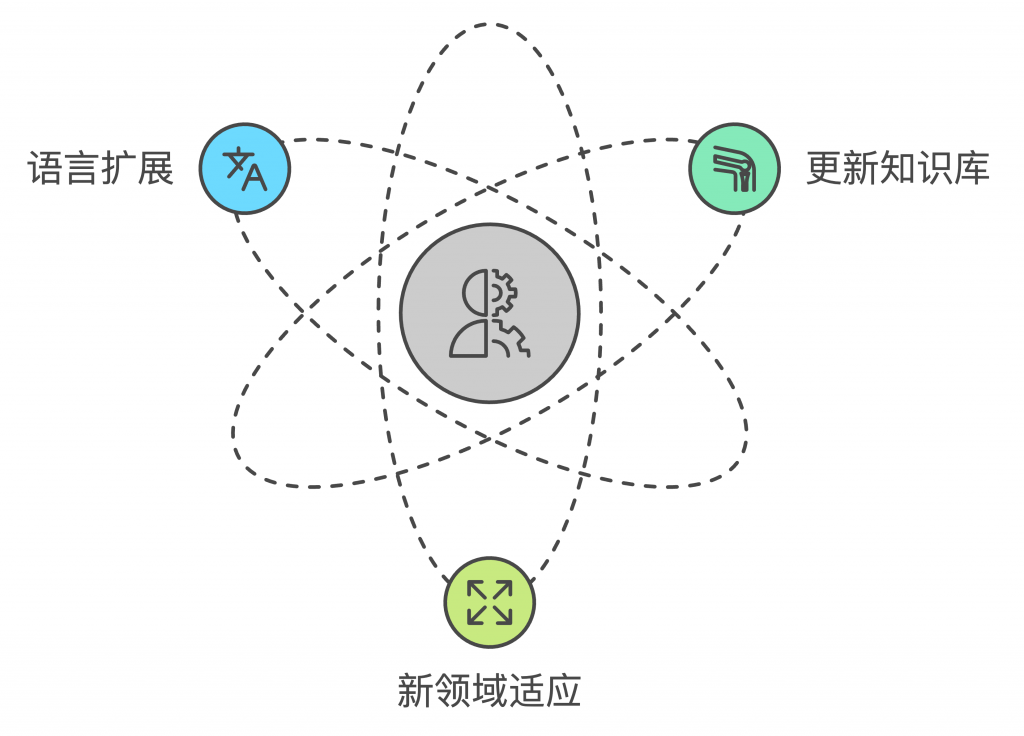

持续预训练用例:

`案例1:更新知识库

- 场景:医疗领域新研究文献更新

- 做法:使用最新医学文献进行持续预训练

- 效果:模型掌握最新医学发展

案例2:新领域适应

- 场景:进入新的市场或行业

- 做法:使用该行业的专业文档进行预训练

- 效果:模型理解行业特定术语和知识

案例3:语言扩展

- 场景:增加新的语言支持

- 做法:使用目标语言的大量文本进行预训练

- 效果:模型获得新语言能力

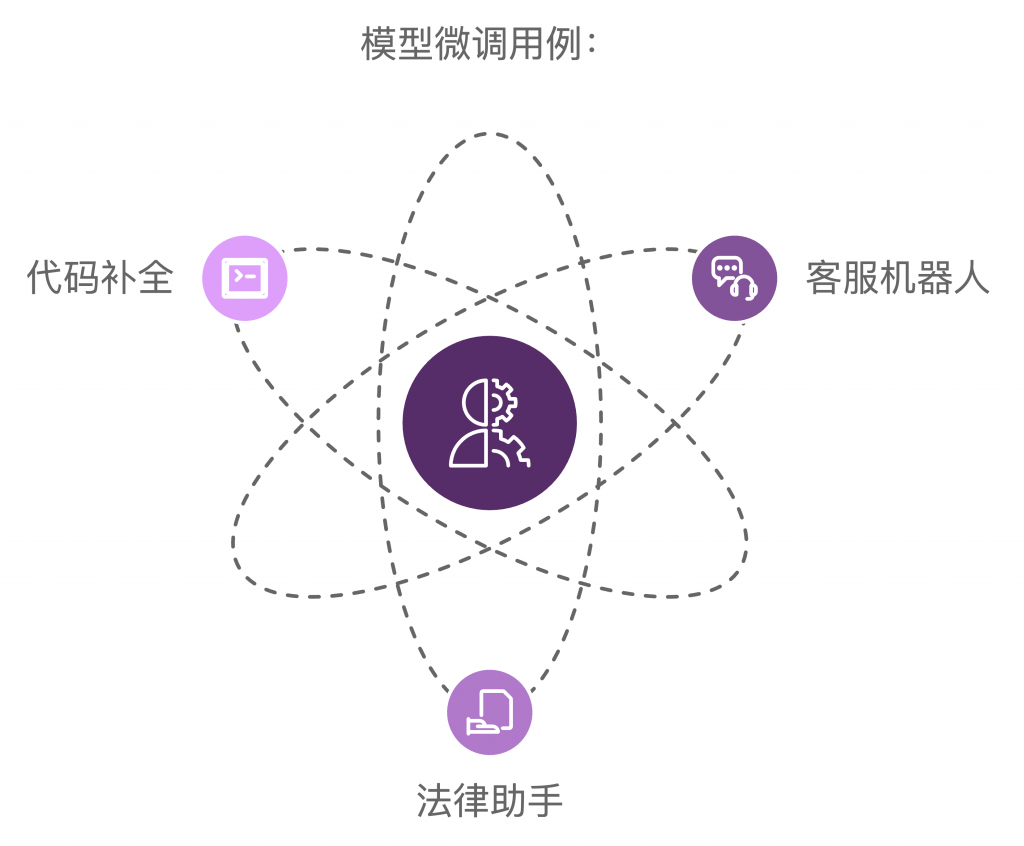

模型微调用例:

`案例1:客服机器人

- 场景:企业特定产品支持

- 数据:问题-答案对

- 效果:准确回答产品相关问题

案例2:法律助手

- 场景:特定法律文书生成

- 数据:文书模板和示例

- 效果:生成规范的法律文档

案例3:代码补全

- 场景:特定编程语言补全

- 数据:代码片段对

- 效果:提供准确的代码建议`

核心区别

训练规模:

- 持续预训练:大规模训练

- 模型微调:小规模定向训练

数据要求:

- 持续预训练:大量未标记数据

- 模型微调:少量高质量标记数据

学习目标:

- 持续预训练:通用能力提升

- 模型微调:特定任务优化

选择建议

何时选择持续预训练:

- 有大量新领域数据需要学习

- 需要更新模型的基础知识

- 要扩展模型的语言能力

- 有充足的计算资源

何时选择模型微调:

- 有明确的任务目标

- 有高质量的标记数据

- 需要快速适应特定场景

- 计算资源有限

最佳实践流程:

- 先进行持续预训练扩展基础能力

- 再进行模型微调优化具体任务

- 定期评估效果并调整策略

- 持续收集反馈进行优化

这种理解和区分对于在AWS Bedrock上开发AI应用非常重要,能帮助我们根据实际需求选择合适的训练策略。

0 responses on "模型微调和持续预训练的区别"